强化学习概述

1. 定义

通过从交互中学习来实现目标的计算方法:

强化学习主要包括三个方面:

- 感知:在某种程度上感知环境的状态

- 行动:可以采取行动来影响状态或者达到目标

- 目标:随着时间的推移最大化累积奖励

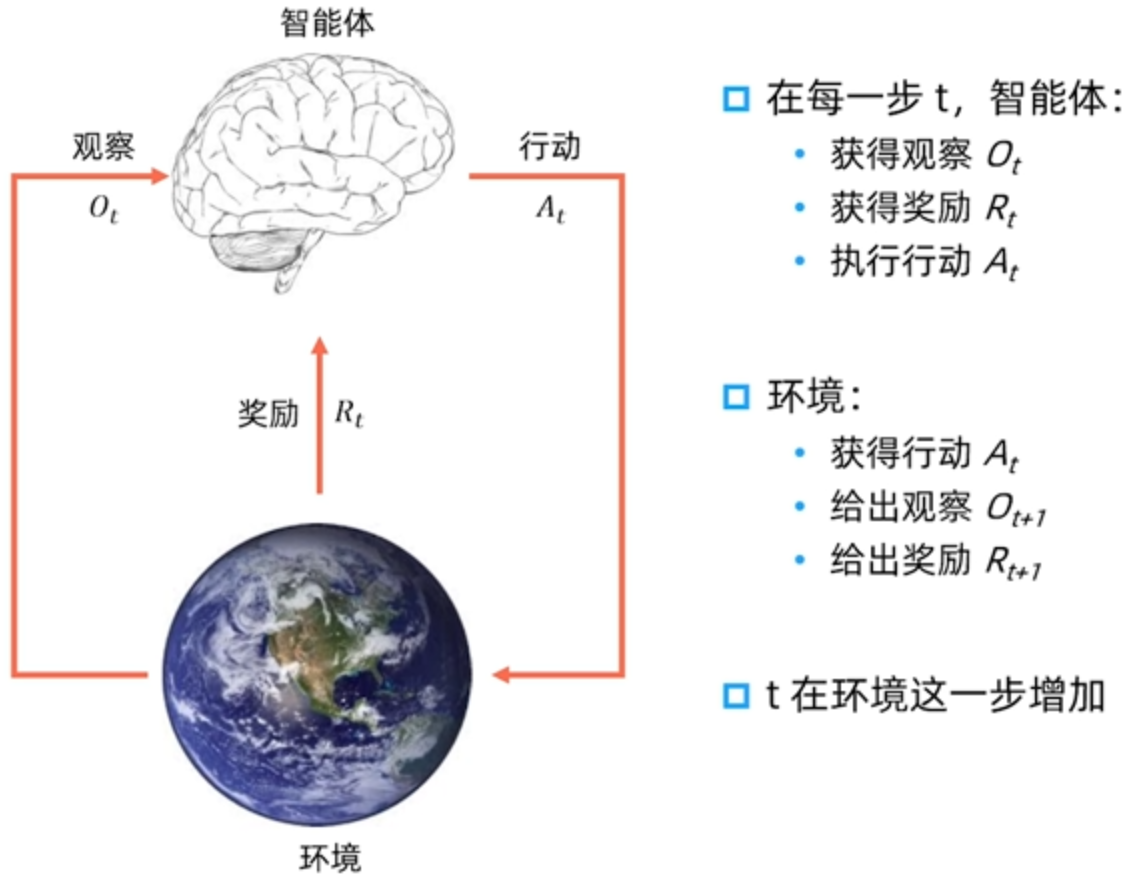

2. 交互

强化学习与环境交互过程如下图:

3. 系统要素

-

历史(History):是观察、行动和奖励的序列。即一直到时间 为止的所有可观测变量:

-

状态(State):一种用于确定接下来会发生的事情的信息。状态是关于历史的函数:

-

策略(Policy):是学习智能体在特定时间的行为方式,是从状态到行动的映射。

-

确实性策略:

-

随机策略:

-

-

奖励(Reward):定义强化学习目标的标量,能立即感知到什么是「好」的。

-

价值函数(Value Function):状态价值是一个标量,用于定义对于长期来说,什么是「好」的。价值函数是对于未来累积奖励的预测:

-

环境模型(Model):用于模拟环境的行为。

-

预测下一个状态:

-

预测下一个奖励:

-

本博客所有文章除特别声明外,均采用 CC BY-NC-SA 4.0 许可协议。转载请注明来自 お前はどこまで見えている!

评论

WalineTwikoo